Italia

La comprensione del parlato spontaneo e le applicazioni dei processi di trattamento automatico del linguaggio sono stati i temi centrali attorno a cui si è discusso al 4° Seminario Bordoni: “La comunicazione vocale uomo-macchina“, il nuovo appuntamento del ciclo di seminari organizzato dalla Fondazione Ugo Bordoni, su un argomento particolarmente importante in termini di applicazione e prospettive future nei settori della PA e delle istituzioni in genere, oltre che nei mezzi di comunicazione e in diversi altri comparti industriali.

Il Seminario si è svolto con il supporto tecnico organizzativo di Isimm.

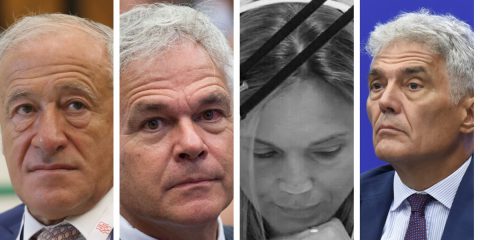

Ospite di rilievo della giornata è stato Renato De Mori, docente all’Università di Avignone e alla Mc Gill di Montreal, IEEE Yellow e Distinguished Lecturer, uno dei massimi esperti al mondo di ‘Speech processing’, le tecnologie vocali e di trattamento automatico della lingua parlata.

Maurizio Dècina, Presidente della Fondazione Ugo Bordoni, nell’aprire la sessione mattutina dei lavori ha presentato De Mori come uno degli studiosi di Speech communication di maggior prestigio, nonché responsabile del progetto europeo LUNA, che ha come obiettivo la comprensione e la traduzione del linguaggio parlato spontaneo da dispositivi tecnologici.

L’uomo ha da tempo ambito ad un rapporto comunicativo diretto con gli oggetti, perché una ‘cosa’ che sia in grado di comunicare, che sia in grado di ‘parlare’, diviene subito oggetto di relazione. Finalmente, qui, siamo a un passo decisivo nella storia della tecnologia, dai primi ‘oggetti parlanti’ di inizio Novecento siamo arrivati alle ‘macchine parlanti’ degli anni Ottanta, fino alle macchine odierne in grado di comprendere i linguaggi parlati.

L’intervento di De Mori ha evidenziato in modo chiaro ed efficace qual è lo stato dell’arte, quali sono le principali applicazioni possibili e quali i risultati ottenuti nella comprensione del linguaggio parlato spontaneo da dispositivi tecnologici, senza comunque dimenticare i limiti che le macchine ancora presentano in questa fase di rapido sviluppo.

Partendo da quello che è lo stato dell’arte, De Mori ha introdotto subito un autorevole punto di vista sul panorama della comunicazione uomo-macchina: “Siamo molto più avanti di quello che pensiamo, certo i sistemi non sono perfetti, ma le applicazioni rispondono in modo positivo, soprattutto nella ricerca di documentazione e nel campo delle telecomunicazioni. I risultati sono, infatti, confortanti sul lato del Re-calling parameters, cioè i parametri utilizzati per valutare la ricerca documentaria, come a livello scientifico con i metodi di modellizzazione stocastica, o i modelli di valutazione di ipotesi, o quelli per la valutazione del segnale vocale. Certo il cammino è lungo, anche perché non siamo così sicuri di riuscire nella mappatura o nella modellizzazione dei linguaggi naturali tramite strumenti meramente matematici“. Continua il Professore dicendo: “i tassi di errore relativo non sono molto alti e questo ci rende più sicuri e propositivi. In ambienti acustici controllati, senza rumors e con apparecchiature di registrazione come il microfono per lo speaker di buon livello e un vocabolario di meno di 1000 parole, osserviamo un tasso di errore WER – Word Error Rate, al di sotto dell’1%; mentre in una situazione con vocabolari di Broadcasting news di almeno 60.000 parole, il tasso di errore sale attorno al 10%, valore comunque soddisfacente“.

Ma che cosa è esattamente il riconoscimento del parlato? Renato De Mori molto semplicemente lo ha sintetizzato come quel processo attraverso cui un computer, o un altro tipo di macchina, riconosce il linguaggio parlato. In altri termini, attraverso questo processo, si può parlare ad un computer e fare in modo che questo identifichi correttamente le parole pronunciate producendo un feedback di senso. “Comprendere il linguaggio parlato significa interpretare una serie di segni convenzionali, cercando nello stesso tempo di ottenere una precisa rappresentazione concettuale proprio del linguaggio naturale“, ha continuato De Mori, affrontando i diversi approcci scientifici alla costruzione dei modelli per il riconoscimento del parlato ASR, Automatic Speech Recognition. “La prima cosa da fare è identificare i ‘segni’ all’interno del linguaggio tramite l’utilizzo di strumenti matematici e statistici, questi poi a loro volta saranno organizzati in sequenze di simboli lessicali che rappresenteranno una versione semantica del linguaggio analizzato“. Da questo primo processo di analisi semantica del parlato si passa poi alla sua codifica, momento in cui le parole che costituiscono il discorso verranno processate in sequenze di segni che la macchina sarà in grado di riconoscere e successivamente decodificare in ulteriori sequenze di concetti ipotetici, su cui lavorare per costruire strutture di data-base. “Si tratta di trasformare una frase in un messaggio vocale, in uno speech signal con differenti livelli di rappresentazione simbolica. Il computer sarà così in grado di produrre, tramite i modelli visti, le medesime rappresentazioni simboliche per gli stesso segnali, in ogni momento. Il trattamento del linguaggio parlato effettuato dalla macchina segue in realtà le stesse regole e gli stessi modelli interpretativi del processo p2p, teso ad ottenere gli stessi risultati per la comunicazione uomo-macchina “.

Stesse regole quindi del linguaggio parlato, affidate a modelli deterministici quali il Language model o il modello di Grammatica generativa, sequenze di parole combinate tra loro in base a regole di probabilità statistica per decine di migliaia di tracciati linguistici utilizzabili. Ma come ha precisato De Mori: “Il linguaggio parlato dagli uomini quasi mai aderisce alla struttura grammaticale della lingua, per tutta una serie di motivi legati alle correzioni in tempo reale effettuate sul parlato dallo speaker, alle esitazioni, alle variabili emotive, alle ripetizioni, agli errori, a irregolarità di pronuncia e ai rumors ambientali. Proprio questi ultimi sono la causa principale di errore nella decodifica della macchina, perché l’ambiente è la variabile più difficile da trattare “. Le tecniche di riproduzione automatiche del discorso devono essere rafforzate proprio su questo punto, che l’analisi sintattica e semantica del linguaggio permette di analizzare al meglio assieme ai vari modelli di trattamento dei dati a disposizione.

In una breve parentesi storica, l’intervento di De Mori ha evidenziato come negli anni si sia passati da una prima fase in cui i modelli lavoravano sulle parole a una seconda in cui da queste ultime si è passati ai concetti. Il processo oggi prevede una mappatura di tipo matematico delle frasi, in cui, utilizzando dei Frame scheme, i concetti si legano alle parole, ad esempio: una località a una città, un’area a una provincia, un paese a una nazione. Tecniche di rappresentazione simbolica degli oggetti, da cui estrarre delle ipotesi di concetti utili ai processi di etichettatura dei documenti. In questo modo la macchina, individuando i concetti dalle parole dell’utente, ad esempio nei servizi di customer service telefonici, trova l’operazione di riferimento e indirizza il cliente al servizio desiderato.

De Mori ha poi brevemente presentato il progetto europeo LUNA che cerca di affrontare le variabili indipendenti dell’ambiente, come l’adozione di vocabolari diversi in uno stesso contesto: “L’obiettivo LUNA a medio termine è quello di ottimizzare il modello di Natural language generation systems, per applicazioni istituzionali che sociali come ad esempio nei casi: ‘How may I help you’ dell’AT&T o il progetto Sistema 3000 di France Telecom. Il nostro fine è cercare di arrivare ad un tasso di errroe CER, Concept Error Rate, al disotto del 10% per le applicazioni sperimentate in modelli generativi di grammatiche stocastiche, la cui utilità è rilevante nel trattamento automatico del linguaggio“. A chiusura del suo lungo intervento De Mori ha ricordato che, tra i risultati ottenuti ed elencati, ci sono sicuramente delle prospettive molto importanti da tenere in considerazione e da seguire con interesse, tra cui la recente attività di trattamento automatico del linguaggio applicato a più lingue.

Nella successiva tavola rotonda “Opportunità applicative del riconoscimento automatico del parlato” della sessione pomeridiana del Seminario, sono stati illustrati i principali vantaggi ottenuti con l’introduzione dell’interfaccia vocale in particolari ambiti applicativi. Sono stati, inoltre, mostrati gli ulteriori progressi possibili in diversi segmenti del mercato. La tavola è stata aperta da Alessandro Ovi della Fondazione Bordoni, che prima di lasciare spazio agli ospiti del mondo della ricerca e delle istituzioni ha evidenziato come le macchine siano ancora fortemente dipendenti dai comportamenti degli utenti e dall’ambiente in cui vengono utilizzate, anticipando di fatto il primo intervento di Andrea Paoloni della FUB, incentrato sui progetti della Fondazione Bordoni sul trattamento automatico della lingua.

“Le attività della FUB in tema di trattamento automatico della lingua“, ha spiegato Paoloni, “vanno dal Forum TAL al progetto Passaporto per l’Italia a cui hanno partecipato anche le Teche Rai, fino a IDEM, attività sul riconoscimento dell’identità del parlante. A questi progetti possiamo aggiungere Trascri, sperimentazione sulla trascrizione automatica in ambito giudiziario e gli studi sperimentali sul corpus del parlato emotivo (…). Si tratta di progetti nati per sperimentare e affinare nuove tecniche di speech processing e text processing, attraverso sinergie vincenti come quelle attivate tra il Langhtech 2008, il Forum PA e molti altri attori, finalizzate anche allo sviluppo di un mercato e alla raccolta di nuovi finanziamenti. (…) Tra i membri di questi progetti vi sono CNIPA, Expert System, FUB e CNR”. L’intervento di Paoloni, riallacciandosi ai punti fissati nell’incontro mattutino, è ritornato sulla comunicazione uomo-macchina, fissando l’attenzione sul riconoscimento identitario del parlante: “IDEM propone un metodo oggettivo semiautomatico di riconoscimento dello speaker in grado di individuare e analizzare gli elementi vocali evidenziati attraverso parametri di similarità e mettendoli a confronto con sistemi statistico probabilistici”. I modelli utilizzati sono dunque semiautomatici, perché alla fine del processo di analisi e comparazione è sempre l’uomo che deve intervenire per monitorare i risultati ottenuti con modalità parzialmente automatizzate, come nel caso del Modello Tascri, utilizzato in ambito giuridico.

Le tecnologie di trascrizione automatica delle sedute giuridiche potrebbero trovare un diffuso utilizzo nei tribunali, come ha bene evidenziato nel suo intervento Giuseppe Cernuto del Tribunale di Milano, che lo ha definito: “un sistema che potrebbe rivoluzionare l’organizzazione del lavoro e dei servizi negli uffici dei tribunali“. A riguardo Cernuto mostra in modo molto chiaro quelli che sono i risultati di progetti di sperimentazioni sul riconoscimento vocale: “un software di dettatura per redigere atti e provvedimenti giudiziari, una sua integrazione con i registri e la verbalizzazione automatica in sede di processo civile e nel lavoro del Pubblico Ministero. Tre sperimentazioni che ci metteranno in grado di trasformare radicalmente il settore giuridico anche valutando quelle che saranno le tecnologie a disposizione e i risultati delle loro applicazioni. Al momento il progetto vede l’utilizzo di questionari sottoposti all’attenzione del personale ministeriale e dei tribunali, otto sperimentatori disposti su dodici postazioni di lavoro, con un’ampia rappresentazione dei diversi aspetti del lavoro di un magistrato e con i relativi lessici di specifica. Proprio su quest’ultimo punto è emersa la difficoltà della gestione della variabile linguistica legata all’alto numero di specializzazioni e di contesti tra loro diversissimi“. Quindi anche in questo caso ciò che emerge con forza è la variabile del contesto e dei linguaggi che, a seconda del mestiere, rendono difficile una loro standardizzazione utile ai trattamenti automatici dei linguaggi.

Un problema, quello del linguaggio, che è stato al centro dell’intervento di Federico Albano Leoni dell’Università La Sapienza di Roma: “Nel trattamento automatico della lingua e del linguaggio resta basilare la comprensione del corpora dell’italiano parlato, in un’analisi che affronti il problema mettendo in relazione le parti e il tutto, come la parola con la frase, o la frase con il corpo del testo. Bisogna rifarsi ai trattati di linguistica di Husserl e allo Strutturalismo novecentesco, come anche alla Psicologia delle forme e della percezione. Pensare le parti come componenti di valore a sé stanti è possibile, ma quale può essere il loro valore in relazione al tutto? Sono le condizioni di partenza e i contesti di riferimento a fissare l’equazione parti = tutto e a rendere valido un sistema, altrimenti questo non sarebbe utilizzabile. Le parole, le parti della frase, se estrapolate e valutate a sé non avrebbero senso, quindi non è solo un problema fonetico, ma di concetto (…). L’attenzione va posta sul contesto di riferimento come condizione necessaria alla comprensione del tutto e all’individuazione delle sue parti più importanti. Senza dimenticare l’importanza vitale del ‘non-detto’ all’interno di un discorso, elemento di difficile modellizzazione e comprensione da parte della macchina“. Un punto quest’ultimo di notevole spessore concettuale e che pone l’accento su un ulteriore passo da compiere che è quello dell’urgenza di una banca dati del lessico, su cui si era soffermato anche Renato De Mori.

Dello stesso avviso Sebastiano Bagnara dell’Isimm, docente all’Università di Sassari-Alghero: “La comunicazione uomo-macchina non va intesa solo nel senso vocale, ma anche nelle sue intenzioni non verbali, nel non detto più ampio, perché non sempre la comunicazione verbale è possibile. La percentuale di errore nei processi appena visti è alta, si pensi alle trascrizioni delle diagnosi giuste nelle strutture sanitarie, nei rilevatori automatici vocali dei call center telefonici, contesti o ambienti virtuali in cui le irregolarità e le opacità di sistema rendono l’applicazione delle tecnologie vocali difficili e i risultati molto ambigui“. Di nuovo il contesto quindi, ancora chiamato in causa a rendere difficoltosa ogni applicazione di trattamento automatico.

Contesto che anche Andrea Marro di AMUSER ha ricordato essere il vero ago della bilancia unitamente al ruolo fondamentale delle interfacce: “Le tecnologie sono legate indissolubilmente a dei bisogni da soddisfare. Se anticipano di troppo questi bisogni o li soddisfano male, queste saranno inevitabilmente condannate al fallimento, come i dispositivi vocali della Renault 11 nei primi Anni ’80, o l’ Interactive Voice Response della Telecom 1412 o della Tim 4444. La tecnologia di per sé non è il driver del progresso senza la soddisfazione di esigenze sociali emergenti nel contempo. Bisogna evitare facili entusiasmi e saper valutare bene il contesto su cui ci muoviamo con un monitoraggio attento al sociale e al mercato, ai prezzi come variabile da non tralasciare e alle interfacce. Una buona interazione con la macchina, anche vocale, passa per un’interfaccia piacevole e funzionale“. All’intervento di Marro sono seguiti gli interventi di Floretta Rolleri e Piero Cosi.

Floretta Rolleri, in rappresentanza del CNIPA, sostiene che: “Una buona interfaccia risolve molti problemi di rapporto tra utente e macchina, anche in funzione di una diffusione urgente e necessaria nel mondo della PA e dell’e-govenrment in generale. Soprattutto in termini di diritti del cittadino a un’amministrazione più veloce, funzionale e pratica, senza dimenticare l’importanza decisiva della diffusione di tecnologia a livello sociale e nel rapporto tra stato e cittadino. Solo così possiamo battere il Digital divide e nel contempo ottenere dei risultati in termini di eSociety“.

Per Piero Cosi del CNR: “Gli entusiasmi sono basilari nella ricerca tecnologica e sono una necessità per andare avanti, proprio in Italia dove, alla scarsità di mezzi e strutture, si affianca una latitanza delle istituzioni. Si pensi alla Francia, alla Germania, agli USA o al Giappone, dove alle strutture si uniscono i mezzi a disposizione, come enormi data-base del lessico, con corpora linguistici ottimamente sviluppati per il trattamento automatico dei linguaggi. Al case study di Portland nella comunicazione macchine-diversamente abili, o a quello nel Colorado sempre negli USA, con l’interazione parole-immagini nel trattamento automatico“.

Sulla mancanza di mezzi e in particolare di data-base funzionali si è soffermato anche Pasquale Santoli delle Teche Rai: “Da una decina di anni si sta procedendo al recupero e allo stoccaggio del materiale audio-video della Rai. Parliamo di un milione di ore ancora da passare al lavoro, con costi e tempi di esecuzione davvero troppo alti. Ecco perché lo sviluppo e il miglioramento delle tecniche di trattamento dei linguaggi è per noi importantissimo per la riduzione dei costi e dei tempi per l’immane opera di trascrizione e segmentazione dei filmati o delle trasmissioni radio, dove anche le tecnologie per il riconoscimento dello speaker potrebbero dare grandi contributi all’analisi e alla catalogazione dei contenuti, lavoro davvero difficile e lungo se affrontato con metodi tradizionali“.

Ulteriori spunti di discussione sono stati offerti anche dagli ultimi due interventi di Luciano Piovano e Alessandro Tescari, sulle possibili applicazioni delle tecnologie vocali, rispettivamente in rappresentanza di Loquendo e PerVoice. Il primo, presentando una panoramica delle attuali e future applicazioni delle tecnologie vocali e del riconoscimento del parlatore, ci evidenzia che: “Noi della Loquendo stiamo cercando di render fruibili le tecnologie vocali nell’Intelligence comunicativa in chiave anti-terrorismo e nelle operazioni della polizia investigativa, come anche nel riconoscimento del parlato nelle chiamate di emergenza verso il 118” .

Molto interessanti le osservazione di Alessandro Tescari sugli utilizzi della tecnologie di trascrizione automatiche della voce in relazione a dei case study in via di sperimentazione con ottimi risultati, soprattutto in sede istituzionale, con le dimostrazioni delle operazioni svolte alla Camera dei Deputati e al Consiglio Regionale della Sardegna: “L’analisi automatica del parlato spontaneo è molto legata, nel suo risultato finale, al contesto di riferimento. In un contesto ottimale, infatti, le performance risultano eccezionali, ma anche per ambienti più difficili pensiamo di poter ottenere risultati migliori del passato. Quello che vogliamo fare è creare un nuovo approccio alla speech analysis, aprendo nuove vie ai mercati, nelle telecomunicaizoni, nelle trasmissioni audio-video televisive e su internet, arrivando a vendere servizi e prodotti di trascrizione e dettatura di alta qualità e per diversi utilizzi in sempre nuovi segmenti di mercato“.

A chiusura della lunga e densa giornata di discussioni e dibattiti molto propositivi sull’ampio tema delle tecnologie vocali e delle loro applicazioni, Alessandro Ovi ha ricordato “quanto ancora ci sia da lavorare in funzione di un livello migliore di comunicazione uomo-macchina (…) e come la tecnologia rimanga sempre una soluzione a un problema, un mezzo e mai un puro fine “. La tavola rotonda si è così sciolta con un saluto caloroso al Professor De Mori, ospite della sessione mattutina e rimasto tra il pubblico come attento ascoltatore fino alla fine.

Il prossimo appuntamento dei Seminari Bordoni avrà come tema “Nuove piattaforme per la radiodiffusione della tv digitale” e si svolgerà il 2 aprile 2008.

Per approfondimenti:

De Mori

De Mori

Le tecnologie vocali sono inutili

Andrea Marro

Applicazioni di riconoscimento del parlatore

Luciano Piovano

Opportunità applicative del riconoscimento automatico del parlato: il futuro della ricerca

Piero Cosi

Progetti nell’area del Trattamento Automatico della lingua (TAL)

Andrea Paoloni

Nuove applicazioni del riconoscimento vocale: FlyScribe

Alessandro Tescari