Si è svolto lo scorso 4 Aprile 2017 presso la biblioteca del Senato a Roma il convegno “Cybersecurity: il lato oscuro del digitale” organizzato dal comitato tecnico scientifico del CSI Piemonte e dal CLUSIT.

CSI è il Consorzio per il Sistema Informativo della pubblica amministrazione piemontese che gestisce i servizi regionali ICT in diversi settori: dalla sanità alle attività produttive, dai beni culturali ai sistemi amministrativi, dal territorio alla formazione professionale e al lavoro. Fondato dalla Regione Piemonte, Università e Politecnico di Torino, al CSI sono oggi consorziati oltre 120 enti pubblici piemontesi.

CLUSIT è una delle più autorevoli associazioni italiane nel campo della sicurezza informatica. Nata nel 2000 presso il Dipartimento di Informatica dell’Università di Milano, oggi rappresenta oltre 500 organizzazioni. CLUSIT è inoltre nota per il suo annuale Rapporto sulla Sicurezza che fornisce il quadro più aggiornato sulla cybersecurity in Italia.

Il CSI Piemonte ha organizzato con CLUSIT questo incontro per promuovere una collaborazione tra le organizzazioni pubbliche e private, in linea con i provvedimenti del Governo a livello nazionale e contribuire alla salvaguardia del sistema Paese. Tra le relazioni illustrate durante l’incontro al Senato, una in particolare — forse la meno compresa dai politici presenti — merita di essere ulteriormente approfondita: il Progetto SHIELD, di cui è stato relatore Antonio Lioy, Professore Ordinario al Dipartimento di Informatica del Politecnico di Torino.

IL PROGETTO SHIELD

SHIELD è un ambizioso progetto di ricerca e sviluppo sulla sicurezza informatica, co-finanziato dalla Commissione Europea all’interno di Horizon 2020 “Secure societies — Protecting freedom and security of Europe and its citizens (H2020-EU.3.7.)”, il più grande programma di ricerca e innovazione dell’UE nel periodo 2014–2020. Lo scopo di SHIELD è di progettare e sviluppare soluzioni innovative per la sicurezza delle informazioni Security-as-a-Service (SECaaS) per gli ISP e per i data center delle grandi imprese.

Il consorzio SHIELD è composto da 11 partner europei, distribuiti tra persone giuridiche, imprese private, grandi aziende, enti di ricerca e partner accademici. Per l’Italia partecipano al consorzio Agenzia per l’Italia Digitale (AgID) e il Politecnico di Torino.

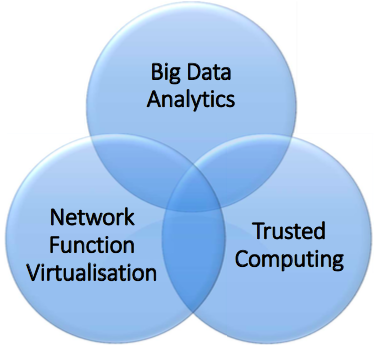

Il Progetto SHIELD combina tecnologie come Network Function Virtualization (NFV), Big Data Analytics e Trusted Computing (TC) al fine di fornire la “security” come un servizio integrato nell’infrastruttura di rete. Una soluzione che — secondo il relatore del progetto — sarà affidabile, adattabile, veloce e con costi contenuti.

La visione maturata in questi anni nel settore del networking tende ad adottare un nuovo modello di rete: dinamico, flessibile, affidabile e soprattutto sicuro, in grado di adattarsi ai cambiamenti richiesti senza troppi interventi di configurazione e manutenzione.

Una rete con queste caratteristiche può essere sviluppata grazie ad un modello architetturale innovativo come il Software Defined Networking (SDN) e grazie anche ad un nuovo modo di sfruttare le funzionalità degli apparati di rete come il Network Function Virtualization (NFV). Questi due concetti — se pur indipendenti — sono strettamente legati tra di loro e, come vedremo più avanti, portano particolari vantaggi se applicati contemporaneamente.

SOFTWARE DEFINED NETWORKING (SDN)

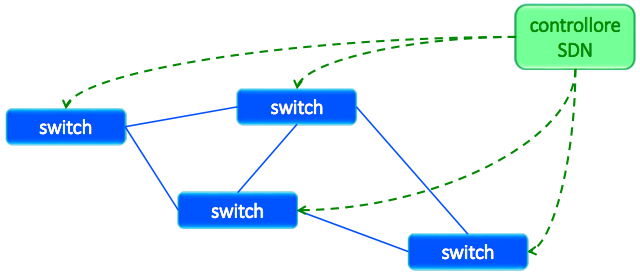

SDN è un’architettura in cui il controllo della rete (control-plane) è disaccoppiato e separato da quello della trasmissione dei dati (data-plane). Il control-plane è la componente intelligente del dispositivo di rete (router, switch, etc) che prende le decisioni sul flusso del traffico del data-plane ed è responsabile della trasmissione delle informazioni di routing oltre che della configurazione e della gestione del dispositivo stesso.

Il routing viene oggi effettuato per percorsi statici attraverso protocolli di instradamento quali ad esempio OSPF o BGP. Questi protocolli sono in grado di stabilire le adiacenze e utilizzano diversi algoritmi per determinare il percorso migliore che il traffico deve prendere.

Con le reti tradizionali ciascun dispositivo gestisce in autonomia e singolarmente i propri control-plane e data-plane e questo non gli consente di avere una visione completa della rete. Indipendentemente dal protocollo di routing utilizzato ogni dispositivo di rete ha quindi una conoscenza parziale dei suoi vicini, dei dispositivi a lui connessi direttamente e — nella migliore delle ipotesi — una consapevolezza comunque circoscritta delle reti nella sua stessa area o all’interno dello stesso Autonomous System (AS).

Con SDN il data-plane viene separato dal control-plane. Quest’ultimo viene gestito in maniera centralizzata per tutti i dispositivi di rete dell’infrastruttura. Questa separazione è l’aspetto più significativo che maggiormente differenzia SDN dalle reti tradizionali.

Software Defined Network è quindi in sintesi un’architettura di rete in cui il controllo della rete (control-plane) è disaccoppiato dalla trasmissione dei dati (data-plane) ed è direttamente programmabile via software da un controller intelligente in grado di visualizzare e gestire i flussi di traffico di ogni dispositivo.

In questo modo la complessità dell’infrastruttura viene notevolmente ridotta a beneficio di una maggiore scalabilità, affidabilità e sicurezza in quanto il controller centralizzato è in grado avere una visione globale dell’intera infrastruttura di rete.

NETWORK FUNCTION VIRTUALIZATION (NFV)

Il processo di virtualizzazione, definito come disaccoppiamento di un servizio dalle risorse fisiche su cui esso opera, ha rivoluzionato negli scorsi anni il modo di creare e gestire i server all’interno dei data center.

Nuove applicazioni come il Cloud Computing e Big Data si sono evolute in molti settori e questo a sua volta ha creato nuove tecnologie che nel corso del prossimo futuro andranno a modificare profondamente anche il mondo del networking consentendogli enormi progressi tecnologici. Una di queste nuove tecnologie è il Network Function Virtualization (NFV).

Si crea a volte una certa confusione utilizzando gli acronimi SDN e NFV come sinonimi ma queste due tecnologie, anche se strettamente correlate, svolgono mansioni differenti.

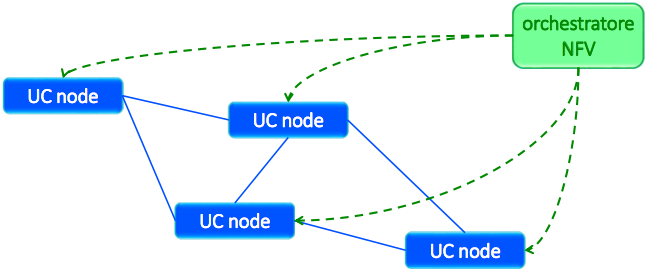

NFV è il processo di virtualizzazione delle funzionalità di rete svolte dagli apparati fisici. Attraverso NFV i servizi di rete non sono più vincolati a differenti hardware specializzati (switch, router, firewall, IDS, etc) ma ogni nodo — fornito di RAM, CPU, NIC e SSD — può svolgere differenti funzioni in accordo con quanto disposto da un orchestratore centralizzato che coordina e gestisce le interazioni e i servizi presenti sull’infrastruttura di rete (NAT, regole di firewall e di routing, etc).

Grazie alla NFV è possibile assicurare una rete più flessibile ed affidabile, potendo spostare le funzioni virtuali (VF) tra differenti apparati e fornendo servizi personalizzati semplicemente rimodulando le attività dell’orchestratore.

Questo comporta anche una serie di benefici in termini economici relativi all’acquisto di nuovi apparati, al consumo di energia elettrica, alla manutenzione e allo spazio fisico necessario per l’alloggiamento dei dispositivi all’interno del data center.

La sinergia tra SDN ed NFV permette alla rete di raggiungere le migliori performance. L’SDN fornisce alla NFV i vantaggi di una connessione programmabile tra le funzioni di rete virtualizzate mentre la NFV mette a disposizione dell’SDN l’opportunità di implementare le funzioni di rete tramite software su server Commercial Off-The-Shelf (COTS).

VIRTUALIZED NETWORK SECURITY FUNCTIONS (vNSF)

Nelle reti tradizionali le funzioni di sicurezza (firewall e IDS/IPS) sono generalmente implementate su apparati proprietari a cui di solito manca una interfaccia di programmazione generale e la loro flessibilità e versatilità è quindi molto limitata. Questi apparati inoltre sono spesso collocati nei punti di ingresso del traffico ed hanno una capacità costante in termini di quantità massima di dati che sono in grado di elaborare.

La natura di questi apparati li rende abbastanza inadatti in un contesto di tecnologie emergenti quali SDN e NFV, in primo luogo perché il perimetro di rete in un ambiente virtualizzato diventa molto fluido e non sempre è possibile individuare in maniera univoca il punto di ingresso del traffico e secondariamente in quanto le applicazioni virtualizzate scalano elasticamente per gestire le variazioni del carico di lavoro e ciò richiederebbe che anche le funzioni di sicurezza che le proteggono debbano scalare di conseguenza.

In terzo luogo le funzioni di sicurezza tradizionali sono spesso delegate a grandi apparati che proteggono intere aree o domini.

Tuttavia in ambienti virtualizzati è sempre più sentito il bisogno di piccole istanze in grado di proteggere specifiche zone o servizi in maniera molto più personalizzata e dinamica.

Per affrontare queste nuove sfide è stato sviluppato vNSF che virtualizza e utilizza le funzioni di sicurezza in maniera molto più dinamica, istanziando rapidamente ed elasticamente le risorse necessarie in base alle variazioni del volume di traffico. vNSF può inoltre riconfigurare le policy di sicurezza in maniera automatica ed in tempo reale.

Questo gli consente di svolgere funzioni di prevenzione e di rilevamento di attacchi attraverso honeypot virtuali in grado di catturare pacchetti dannosi, apprendere e generare modelli matematici e serie storiche delle aggressioni e quindi inviare i modelli ad un IDS/IPS virtuale che provvede ad esercitare le azioni necessarie a tutelare l’infrastruttura e l’erogazione dei servizi.

TRUSTED PLATFORM MODULE (TPM)

Il TPM è un microchip di sicurezza installato sulla motherboard dei server e su molti devices di uso quotidiano. Ogni chip è dotato di una coppia di chiavi crittografiche asimmetriche che consente di identificare e autenticare in modo univoco il dispositivo.

Le firme crittografiche del software (BIOS, bootloader, kernel, applicazioni, configurazioni, etc) abbinate ai chip di sicurezza hardware TPM consentono di convalidare a livello centralizzato ogni attività di avvio, di aggiornamento e di esecuzione del software su ogni apparato presente nel data center. Questo garantisce lo stato di integrità di tutti i nodi che compongono l’infrastruttura di rete.

CONCLUSIONI

SHIELD può essere riassunto come un avanzato sistema di Intrusion Detection and Protection System (IDPS) basato sulle tecnologie SDN, NFV, TPM e DARE (Data Analysis and Remediation Engine) che utilizza il Machine Learning e i Big Data come strumenti di analisi per il monitoraggio della sicurezza delle reti.

Il modello di sicurezza offerto dalla virtualizzazione delle reti supera il modello tradizionale di difesa, la cui configurazione permette la sola tutela del perimetro lungo l’asse nord-sud, cioè lungo l’asse che descrive il percorso dei dati in ingresso e uscita dall’infrastruttura.

La virtualizzazione permette di proteggere anche quello che viene definito l’asse est-ovest del percorso dati, ossia quello tra i differenti servizi in esecuzione all’interno dell’infrastruttura.

Un esempio della validità di questo modello di sicurezza ce lo offrono i data center di Google e di Facebook che — come abbiamo descritto in “La sicurezza nei data center di Google” e “I data centers di Facebook” — già oggi implementano con successo queste nuove tecnologie di difesa.

Le possibili applicazioni di SHIELD spaziano dalle attività interne ai data center delle grandi aziende alle infrastrutture di rete degli ISP — che possono inoltre offrire SHIELD come Security-as-a-Service (SECaaS) ai propri clienti — fino alle agenzie governative o a gruppi di interesse per il monitoraggio delle reti.

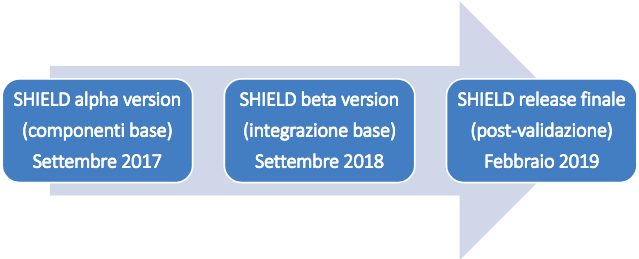

Lo sviluppo di questo progetto prevede il rilascio di una prima versione alpha di SHIELD a Settembre 2017 e una successiva versione beta per il 2018. Il framework su cui si basa SHIELD verrà rilasciato con licenza open-source mentre altri elementi, come l’analytic engine, rimarranno invece proprietari.

Un ringraziamento agli organizzatori di questo interessante convegno, nelle persone di Riccardo Rossotto, Ferruccio Ferranti e Giulio Lughi del CSI Piemonte, Gabriele Faggioli di CLUSIT e ad Antonio Lioy del Politecnico di Torino per la documentazione del Progetto SHIELD, di cui torneremo sicuramente a parlare seguendone l’evoluzione in un prossimo futuro.