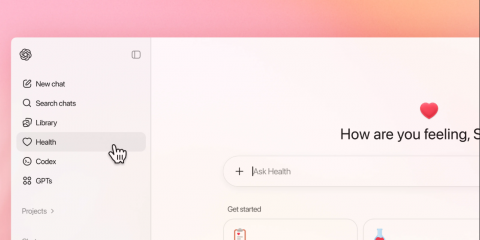

OpenAI apre un nuovo capitolo nell’uso dell’AI per la salute e presenta ChatGPT Salute, un’esperienza dedicata dentro ChatGPT pensata per integrare le informazioni sanitarie. L’obiettivo, nelle parole dell’azienda, è aiutare le persone a sentirsi più informate, preparate e sicure quando devono gestire la propria salute, interpretare dati, prepararsi a una visita o orientarsi tra documenti e app.

Il servizio, per ora disponibile solo con lista d’attesa e fuori da Unione Europea, Regno Unito e Svizzera, consente di collegare cartelle cliniche e app di monitoraggio come Apple Salute o MyFitnessPal, mantenendo le conversazioni separate dal resto dell’esperienza e dichiaratamente escluse dall’addestramento dei modelli.

Ma proprio perché entra in un ambito ad alto rischio, la novità porta con sé una domanda inevitabile: quanto può essere davvero sicuro affidare a un chatbot informazioni sanitarie e decisioni, anche indirette, sulla propria salute?

Rischio di errori o interpretazioni fuorvianti

Anche con una modalità dedicata, ChatGPT resta un sistema probabilistico: può sbagliare, semplificare troppo o dare risposte convincenti ma non corrette. Nel contesto sanitario questo è particolarmente pericoloso, perché l’utente può prendere decisioni basandosi su un’informazione letta “in buona fede”.

Rischio di falsa sicurezza e autodiagnosi

La stessa promessa di “sentirsi più preparati” può trasformarsi in un effetto collaterale: l’utente si affida al chatbot più di quanto dovrebbe, ritarda una visita, cambia terapia senza consulto o interpreta segnali clinici come meno urgenti. È un rischio noto in tutte le tecnologie di supporto alla salute: più l’esperienza è fluida e credibile, più può aumentare la fiducia anche quando non dovrebbe.

Dati personali esposti

Collegare cartelle cliniche e app rende le risposte più pertinenti, ma aumenta la superficie d’attacco. Più dati entrano nel sistema, più diventa delicata la protezione: basta un accesso non autorizzato all’account, una password debole, un dispositivo condiviso o compromesso, per trasformare quell’area “separata” in un bersaglio ad alto valore.

Sicurezza e dipendenza da terze parti

Le integrazioni con EHR e app passano inevitabilmente da soggetti esterni: sistemi sanitari, piattaforme di connessione, provider di app. In pratica, i dati non sono solo “in ChatGPT”, ma viaggiano tra più attori. Ogni attore aggiunge un punto potenziale di vulnerabilità: bug, errori di configurazione, violazioni, o policy non perfettamente allineate. Anche se l’integrazione avviene con consenso esplicito, l’ecosistema è più complesso e quindi più fragile.

Profilazione e usi indiretti

OpenAI dichiara che le conversazioni in Salute non vengono usate per addestrare i modelli di base. È un punto importante. Ma per l’utente medio resta difficile capire la differenza tra training, log, retention tecnica, gestione degli incidenti, controlli interni e analisi aggregate. In generale, ogni volta che una piattaforma gestisce dati sanitari, il rischio non è solo l’abuso diretto, ma anche l’uso indiretto: analytics, trend, segmentazioni, o interazioni con servizi collegati. Per questo la trasparenza sulle policy e la capacità di controllo reale (eliminazione, revoca accessi, gestione delle memorie) diventano centrali.

Bias e mancanza di personalizzazione clinica reale

Anche con dati personali, un chatbot non sostituisce una valutazione clinica: manca l’esame obiettivo, non conosce davvero la storia medica completa, non vede il contesto sociale e familiare, non “misura” i sintomi. Inoltre i modelli possono incorporare bias: ad esempio risposte meno accurate su alcune popolazioni, condizioni rare o casi atipici. Qui il rischio è ricevere indicazioni “standard” su situazioni che standard non sono.

Confini di responsabilità ancora grigi

Quando l’AI entra in un’area come la sanità, la domanda diventa anche: chi risponde se qualcosa va storto? L’azienda specifica che non è un sistema di diagnosi o trattamento, ma nella pratica l’utente può usarlo comunque come se lo fosse. Questa distanza tra “uso dichiarato” e “uso reale” è uno dei punti più delicati e probabilmente sarà oggetto di attenzione regolatoria.

Come può proteggersi un utente (senza demonizzare lo strumento)

- Usarlo come supporto per capire e preparare domande, non per decidere terapie.

- Verificare sempre con un medico quando compaiono sintomi nuovi, intensi o persistenti.

- Non inserire dati identificativi superflui e fare attenzione ai dettagli.

- Attivare l’autenticazione a più fattori e proteggere l’account.

- Valutare se collegare davvero cartelle cliniche e app: è utile, ma va fatto sapendo che si sta aumentando l’esposizione.

- Conservare un’abitudine “critica”: se una risposta sembra troppo netta o rassicurante, è proprio lì che serve il secondo controllo.