Ventidue parole per lanciare un nuovo allarme catastrofico. “L’intelligenza artificiale pone una minaccia esistenziale all’umanità e dovrebbe essere considerata un rischio sociale come le pandemie e le guerre nucleari”.

E’ l’allarme lanciato dai leader del settore in una lettera aperta firmata da più di 350 manager e diffusa dalla no profit Center for AI Safety, un nuovo avviso congiunto che mette in guardia sulle minacce che l’intelligenza artificiale pone sul cammino dell’umanità.

Fra i firmatari della lettera ci sono l’amministratore delegato di OpenAI Sam Altman, il numero uno di Google DeepMind Demis Hassabis e il leader di Anthropic Dario Amodei.

Non è la prima volta che voci autorevoli si levano per avvisare sulle possibili ripercussioni di un uso sconsiderato dell’IA, ma le particolarità di questo “memorandum” sono due: è molto breve (22 parole in inglese), e parla espressamente di rischio di estinzione. “Ridurre il rischio di estinzione a causa della IA dovrebbe essere una priorità globale, al pari di altre emergenze sociali come le pandemie e la guerra nucleare”, si legge.

A marzo è stata pubblicata un’altra lettera aperta, che intimava espressamente di fermare lo sviluppo senza controllo della tecnologia da parte dei giganti del settore. Nella missiva si legge come il Far West dell’intelligenza artificiale, reputata la nuova Eldorado dell’hi-tech, comporti “profondi rischi per la società e l’umanità”. Si chiede anche di fermare per almeno sei mesi la ricerca su sistemi di intelligenza digitale che siano più potenti di GPT-4, l’ultima versione dell’assistente realizzato da OpenAI

La dichiarazione arriva in un momento di crescente preoccupazione per i potenziali danni dell’intelligenza artificiale. I recenti progressi nei cosiddetti grandi modelli di linguaggio – il tipo di sistema utilizzato da ChatGPT e altri chatbot – hanno fatto temere che l’intelligenza artificiale potrebbe presto essere utilizzata su larga scala per diffondere disinformazione e propaganda, o che potrebbe eliminare milioni di posti di lavoro.

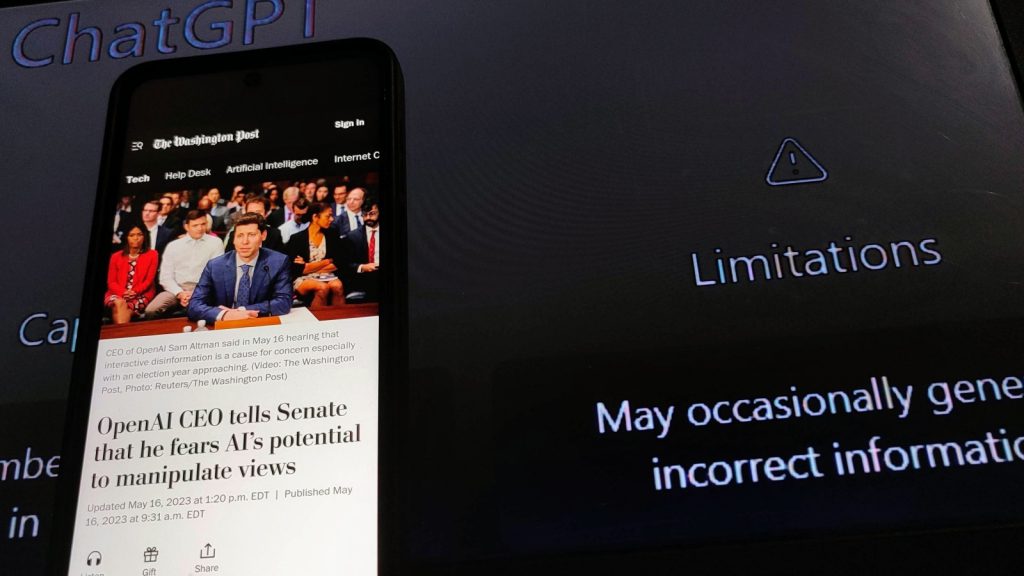

In definitiva, alcuni credono che l’IA potrebbe diventare abbastanza potente da creare perturbazioni su scala sociale entro pochi anni se non si fa nulla per rallentarlo. Queste paure sono condivise da numerosi leader dell’industria. Il CEO di OpenAI Sam Altman, in una testimonianza al Senato dello scorso 17 maggio, ha avvertito che i rischi dei sistemi avanzati dall’IA sono abbastanza seri da giustificare l’intervento del Governo e ha chiesto una regolamentazione per i suoi danni potenziali.

IA e regolamentazione: OpenAI lancia un fondo da 1 milioni di dollari

Dopo le richieste al Senato OpenAI ha lanciato un fondo da 1 milione di dollari per raccogliere idee e proposte sulla regolamentazione dell’intelligenza artificiale. Il fondo è diviso in dieci sovvenzioni da 100 mila dollari ciascuna, da assegnare a ricercatori singoli, organizzazioni e aziende, scelte attraverso una selezione interna.

I premi andranno ai progetti considerati più meritevoli nel complesso panorama odierno che tenta di rispondere ai timori sull’uso dell’IA. I partecipanti possono inviare le loro proposte entro il 24 giugno 2023 ad OpenAI, che le valuterà in maniera trasparente, pubblicando un report finale, liberamente consultabile, in cui verrà spiegato il procedimento di individuazione delle varie iniziative.

Nell’annuncio del nuovo programma, che si pone l’obiettivo di decidere “democraticamente” le leggi a cui un’IA dovrebbe sottostare, OpenAI sottolinea: “Esistono molti modi in cui un tale processo potrebbe essere strutturato: incoraggiamo i candidati a essere innovativi, basandosi su metodologie note e proponendo approcci completamente nuovi. I beneficiari della sovvenzione dovranno implementare un prototipo della loro soluzione, coinvolgendo almeno 500 partecipanti, e pubblicando un rapporto entro il 20 ottobre del 2023”.

Nei giorni scorsi, come risposta al lavoro dell’Unione Europea sul cosiddetto “Eu IA Act”, insieme di norme per regolare lo scenario delle applicazioni di intelligenza artificiale, OpenAI aveva paventato la possibilità di spegnere i suoi progetti, ChatGpt incluso, per gli utenti nell’Unione, qualora l’azienda non riuscisse a dar seguito alle richieste di accesso a dati e informazioni come si evince dalla bozza del documento al vaglio dei legislatori.