Il presidente degli Stati Uniti è impegnato in prima persona per evitare che l’IA generativa vada fuori controllo. Il mese scorso Biden ha incontrato alla Casa Bianca 7 grandi aziende di intelligenza artificiale ed è riuscito ad ottenere da loro una sorta di autoregolamentazione.

Amazon, Anthropic, Google, Inflection, Meta, Microsoft e OpenAI hanno accettato diversi impegni volontari per andare verso uno sviluppo della tecnologia dell’IA senza rischi per l’umanità, sicura dal punto di vista informatico e trasparente.

Gli impegni volontari delle 7 società

Tra l’elenco completo degli impegni ci sono alcune cose significative. Le aziende faranno ampi test di sicurezza e condivideranno informazioni sulla gestione dei rischi dell’IA e la sicurezza informatica sarà una priorità per proteggere se stesse e i loro prodotti dagli attacchi cyber.

Nel frattempo, svilupperanno sistemi – un trademark – una filigrana, per esempio – che consentirà agli utenti di sapere quando il contenuto è stato generato dall’IA. Le aziende studieranno anche i possibili danni che i loro sistemi possono causare e useranno i loro prodotti per aiutare la società, come cercare, più velocemente, una cura per il cancro o mitigare i cambiamenti climatici.

Tra gli impegni presi nessun riferimento a non utilizzare dati che potrebbero violare la privacy delle persone o a risarcire gli utenti quando vengono usati i loro dati.

Ma questi impegni volontari sono sufficienti?

No. Per questo motivo la Casa Bianca ha annunciato che è in lavorazione anche un ordine esecutivo e il presidente Biden spera in una legge bipartisan dal Congresso.

Congresso che ha avviato diverse audizioni, a Samuel Altman – CEO OpenAI, Christina Montgomery – Chief Privacy & Trust Officer IBM, Gary Marcus – Professor Emeritus New York University, Stuart Russell – Professor of Computer Science The University of California, Berkeley, Yoshua Bengio, Founder and Scientific Director of Mila – Québec AI Institute e all’italo-americano Dario Amodei, Chief Executive Officer Anthropic.

Secondo Vox ecco la maggior parte delle idee che circolano per una regolamentazione Usa dell’IA.

- Regole: nuovi regolamenti e leggi per individui e aziende che addestrano modelli di intelligenza artificiale.

- Istituzioni: nuove agenzie governative o organizzazioni internazionali che possono attuare e far rispettare questi nuovi regolamenti e leggi

- Fondi: finanziamenti aggiuntivi per la ricerca, sia per espandere le capacità di intelligenza artificiale che per garantire la sicurezza

- Persone: cercare soggetti altamente qualificati e definire finanziamenti per l’istruzione con l’obiettivo di costruire una forza lavoro in grado di produrre e controllare l’IA.

Il leader della maggioranza al Senato Chuck Schumer ha delineato il suo approccio alla regolamentazione in un discorso di giugno e ha promesso una pronta legislazione improntata ad “alimentare l’innovazione e non a soffocarla”. “Ma”, ha continuato Schumer, “l’IA deve essere sicura” e “deve essere sviluppata in modo responsabile”.

“Come facciamo ad impedire ad aziende di IA di tracciare i movimenti dei nostri figli, inondarli di pubblicità dannose o danneggiare la loro immagine e la loro salute mentale? Come possiamo assicurarci che l’IA non sia utilizzata per sfruttare i lavoratori o incoraggiare i pregiudizi razziali nelle assunzioni? Questi rischi vuole evitare il leader della maggioranza al Senato Chuck Schumer, che ha promesso l’introduzione di guardrail per l’IA, soprattutto per quella generativa.

Ma chissà se e quando il Congresso Usa arriverà a una norma per regolare l’IA?

Nel frattempo, la presidente della FTC Lina Khan si è detta pronta e disposta a utilizzare i mandati di concorrenza e protezione dei consumatori dell’Agenzia per tenere sotto controllo le aziende di intelligenza artificiale. Recentemente ha scritto un editoriale del New York Times sostenendo che le conseguenze della crescita incontrollata del Web 2.0 dovrebbero servire da impulso per le Agenzie ad agire ora sull’IA. La FTC, ha detto, sarà vigile.

“Sebbene questi strumenti siano nuovi, non sono esenti dalle regole esistenti e la FTC applicherà vigorosamente le leggi che deve far rispettare, anche in questo nuovo mercato“, ha scritto Khan.

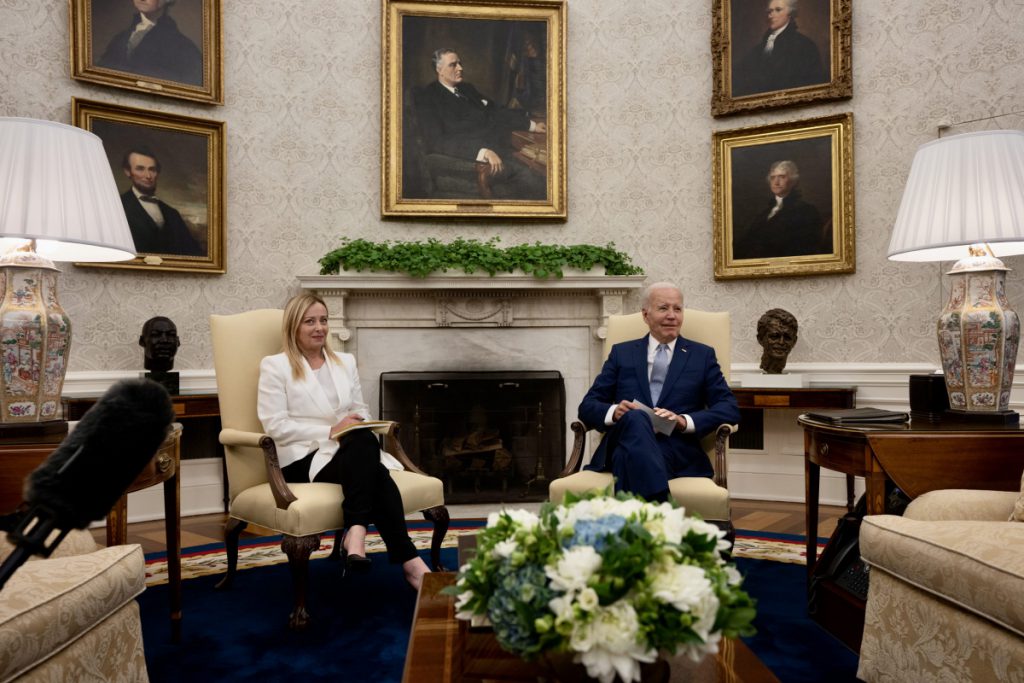

Biden-Meloni, colloquio anche su IA ed etica digitale

Il presidente Biden ha parlato della necessità di regolare l’IA e di etica digitale anche nell’incontro con la premier Giorgia Meloni. Il presidente del Consiglio dei ministri ha poi affrontato il tema dell’intervista rilasciata alcune ore dopo l’incontro alla Casa Bianca a Sky TG24.

“Subito regole sull’IA. La temo perché mette a rischio centralità persona”, ha detto Meloni.

Ricordiamo che qui in Europa siamo già a buon punto sull’iter legislativo per regolare l’IA. Con l’ok del Parlamento europeo all’AI ACT, che racchiude le nuove regole, sono iniziati i triloghi tra i Paesi membri e la Commissione Ue. Ci sono posizioni discordanti fra Eurocamera e Commissione Ue sul riconoscimento facciale e, come ci ha riferito Brando Benifei, europarlamentare Pd/S&D, uno dei due correlatori al testo, “stiamo valutando se accelerare la sua applicazione, subito dopo la sua approvazione, per i grandi sistemi più potenti, come ChatGPT, per non arrivare tardi su alcuni problemi già presenti causati dall’IA generativa”.

Tra i correttivi pensati dall’Ue per l’IA generativa c’è anche l’uso di un trademark – una filigrana, per rivelare se il contenuto è prodotto con ChatGPT o da altre IA generative.

Questa è una delle misure che anche gli Usa vogliono adottare.

Come avvenuto con il GDPR, l’Ue fa scuola nel mondo anche sulla regolamentazione dell’IA. Ma deve accelerare l’iter. Perché l’IA generativa corre veloce offrendo vantaggi per ogni start-up, società e PA, ma anche rischi per le libertà e i diritti delle persone.

L’Italia deve produrre IA

Ovviamente, non si può far morire sul nascere l’IA a causa delle troppe e stringenti future regole. Si deve consentire agli sviluppatori italiani ed europei di produrre Intelligenza artificiale con l’accesso a un fondo di investimenti dedicato e grazie a una regolamentazione favorevole alla sperimentazione.

La ormai famosa “sandbox” normativa per consentire a startup, imprese, università e centri di ricerca di sperimentare progetti innovativi sull’IA attraverso una deroga temporanea alle norme vigenti e future. Se al mare ai nostri bambini diciamo continuamente “non fare questo, non stare troppo tempo al sole, ecc…” non faranno nessun castello di sabbia…