AI, una storia che inizia negli anni ’50 del secolo scorso

L’intelligenza artificiale (AI) è una delle tecnologie più affascinanti e rivoluzionarie del nostro tempo. Ma come siamo arrivati a creare macchine capaci di scrivere testi, riconoscere volti e persino generare opere d’arte? Ripercorriamo insieme le tappe principali di questa straordinaria evoluzione.

Negli anni ’40 e ’50, matematici e filosofi iniziano a chiedersi se una macchina possa pensare. Il geniale Alan Turing propone un test per valutare l’intelligenza di una macchina: se riesce a dialogare con un essere umano senza farsi riconoscere, allora è “intelligente”.

Nel 1956, durante una conferenza a Dartmouth College, nasce ufficialmente il termine intelligenza artificiale. L’obiettivo? Far sì che le macchine imitino il ragionamento umano.

Parte da qui la Keynote Lecture al Digital Innovation Forum – ComoLake 2025 di Cernobbio di Marc Mézard (vincitore del Premio dei Tre FIsici, ex Direttore École Normale Supérieure, Professore ordinario all’Università Bocconi) dal titolo “L’Intelligenza Artificiale: Una Rivoluzione Tecnologica in Attesa di una Teoria”.

Il punto di svolta con le reti neurali

Dopo decenni di sperimentazioni e passi in avanti (e anche passi falsi), si arriva agli anni ’90 del secolo scorso: l’attenzione si sposta sull’apprendimento automatico (machine learning): invece di programmare ogni comportamento, si insegna alla macchina a riconoscere schemi nei dati. Nascono le reti neurali, ispirate al cervello umano, che permettono alle macchine di migliorare con l’esperienza.

Il vero punto di svolta è arrivato nel 2012, un gruppo di ricercatori guidato da Alex Krizhevsky, insieme a Geoffrey Hinton e Ilya Sutskever, ha presentato AlexNet, “una rete neurale profonda, deep neural network, progettata per riconoscere immagini”.

Il modello in questione prese alla competizione ImageNet, “una sfida internazionale per classificare milioni di immagini in migliaia di categorie. AlexNet ha superato di gran lunga tutti gli altri algoritmi, riducendo l’errore di classificazione di oltre il 10%, un risultato mai visto prima”, ha raccontato Mézard.

Da allora, ogni 2-3 anni ci sono stati successi significativi, fino ai Large Language Model (LLM) e al machine learning (ML)

“Sul futuro dell’AI – ha proseguito il Professore della Bocconi – ci sono diverse visioni, dall’Artificial General Intelligence alla Transformative AI, che potrebbe automatizzare gran parte del lavoro intellettuale. È importante considerare le trasformazioni sociali e l’impatto dell’AI sulla scienza e sulla ricerca. Le applicazioni includono nuove molecole, nuovi materiali e il linguaggio”.

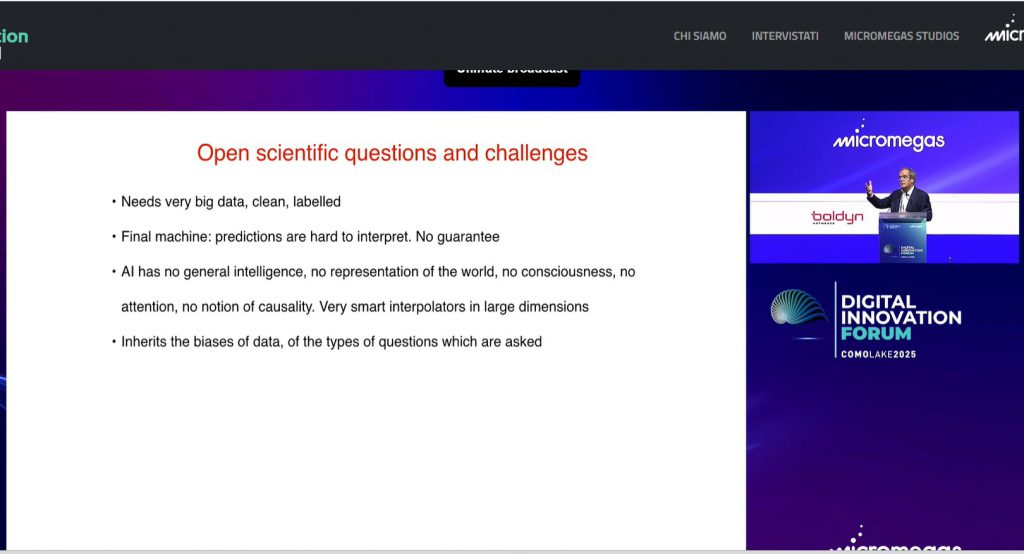

I rischi dell’AI

Ma, ha sottolineato Mézard: “bisogna tenere a mente i pericoli, come la sorveglianza di massa, la generazione di realtà false, il brain reading e le armi autonome. Le sfide sono legate al modo in cui si allena l’AI con il machine learning, che richiede molti dati. A differenza dei bambini, che imparano generalizzando da pochi esempi, i Large Language Model richiedono milioni di esempi”.

“L’AI non ha una vera intelligenza generale – ha precisato il fisico teorico – non ha una relazione con il mondo, non ha la consciousness, non ha l’attenzione e non è capace di capire le causalità. Ci sono problemi legati ai dati. Le sfide più importanti sono la connessione con la computational neuroscience”.

L’interpretabilità è un altro problema, ha detto Mézard: “anche se si conoscono tutti i parametri di un LLM, si capisce poco del suo funzionamento. Questo è legato al fenomeno dell’emergence, in cui l’informazione viene trattata collettivamente da tutti i neuroni”.

In pratica, quando si aumenta la dimensione di un modello linguistico (più parametri, più dati, più potenza di calcolo), compaiono capacità nuove che non erano presenti nei modelli più piccoli. E non si manifestano gradualmente, ma improvvisamente, come se il modello “sbloccasse” una nuova abilità.

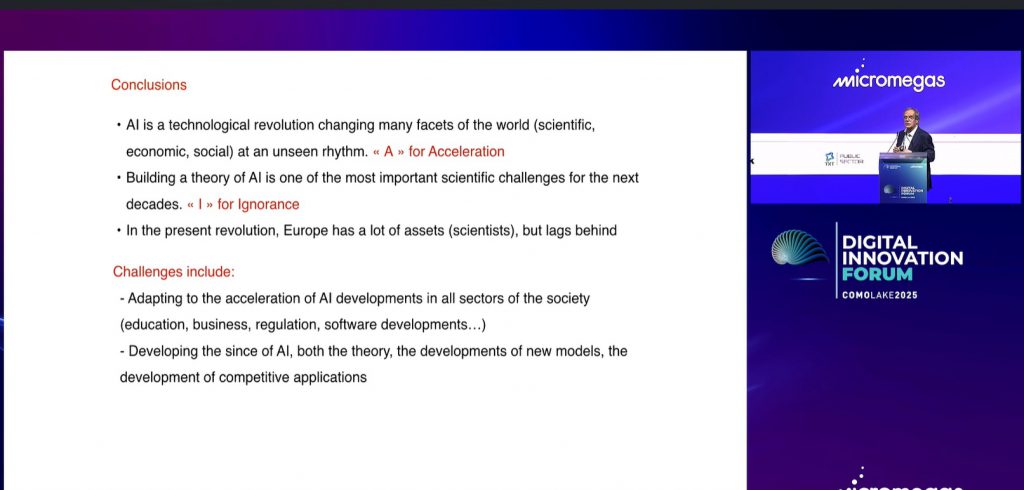

AI: ‘A’ come accelerazione delle scoperte e ‘I’ come ignoranza dei suoi meccanismi di base

In conclusione, ha aggiunto Mézard, si tratta di una rivoluzione tecnologica che sta aspettando di sviluppare una teoria. L’accelerazione delle scoperte è una sfida per tutti: “Dovete ricordarvi due lettere di questa mia presentazione: A, che sta per accelerazione e che rappresenta una vera sfida per tutti, anche per lo sviluppo di una teoria; e I, che sta per ignoranza, perché ancora non capiamo bene fino in fondo i meccanismi di base, non possiamo dire neanche se produrrà o meno allucinazioni”.

“L’Europa ha enormi capacità nell’AI, soprattutto nella ricerca, ma è indietro nello sviluppo dei nuovi modelli e nelle applicazioni, ha un problema di competitività. L’Europa deve trovare un modo per investire nell’AI di frontiera”, ha sottolineato il Professore della Bocconi, “solo così sarà possibile investire nel modo giusto per aumentare capacità e sviluppare modelli all’avanguardia per realizzare in Europa un cero centro di ricerca nell’AI“.