Rubrica settimanale SosTech, frutto della collaborazione tra Key4biz e SosTariffe. Per consultare gli articoli precedenti, clicca qui..

C’è stato un tempo in cui l’intelligenza artificiale generativa – quella di ChatGPT, per intenderci – sembrava davvero minacciosa. Un anno fa fece un certo scalpore la conversazione tra un utente e il motore di ricerca di Bing, potenziato, appunto, da ChatGPT. L’IA si ostinava a ripetere che Avatar 2 non era ancora uscito nelle sale, poiché non era ancora arrivato il giorno del suo debutto, il 16 dicembre 2022. Il problema è che quella conversazione era del 12 febbraio 2023; la confusione creata all’IA dai tentativi di rettifica da parte dell’utente la fece diventare sempre più aggressiva (o “assertiva”, nelle sue parole), fino a sfiorare la minaccia.

Com’era inevitabile, dopo quell’episodio in molti cominciarono a pensare a Terminator e a Skynet, immaginandosi un mondo dominato da robot che non amavano essere corretti sulla programmazione cinematografica dei blockbuster. In poche settimane l’IA divenne molto più accomodante, forse troppo: se chiedevi chi avesse scritto la Divina Commedia e ti veniva risposto “Dante”, e tu ti proclamavi convintissimo che l’autore in realtà fosse il tuo vicino di casa, il più delle volte ChatGPT si scusava per l’imprecisione e riconosceva che sì, naturalmente, «Nel mezzo del cammin di nostra vita» era un parto dell’inquilino del quarto piano.

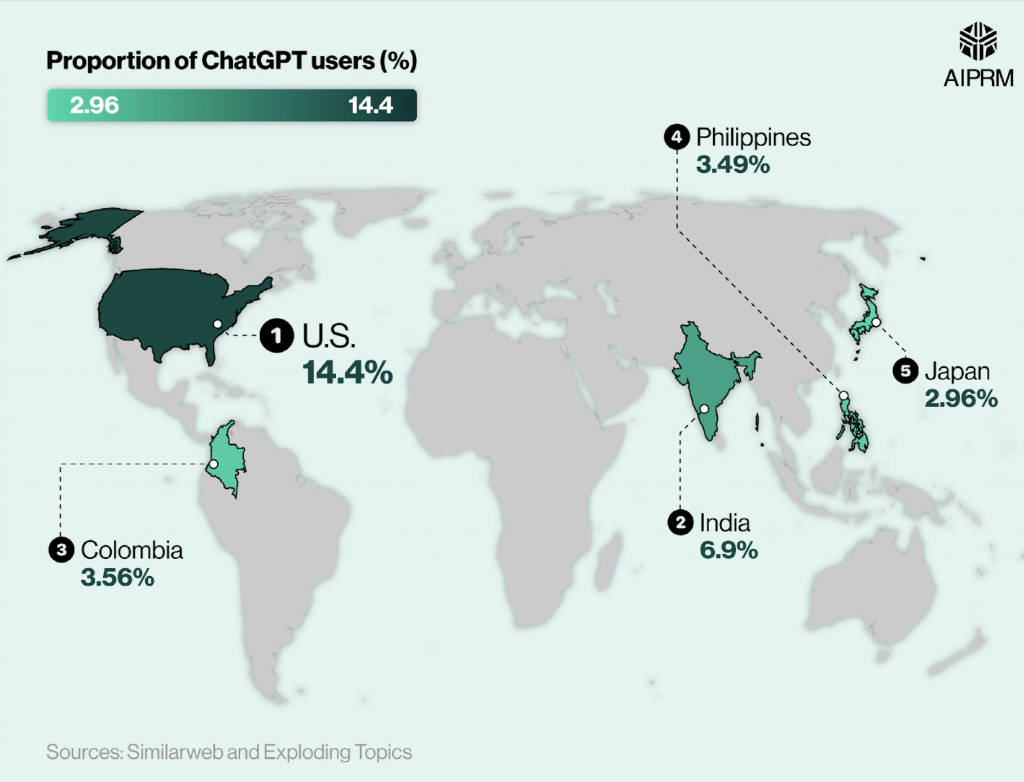

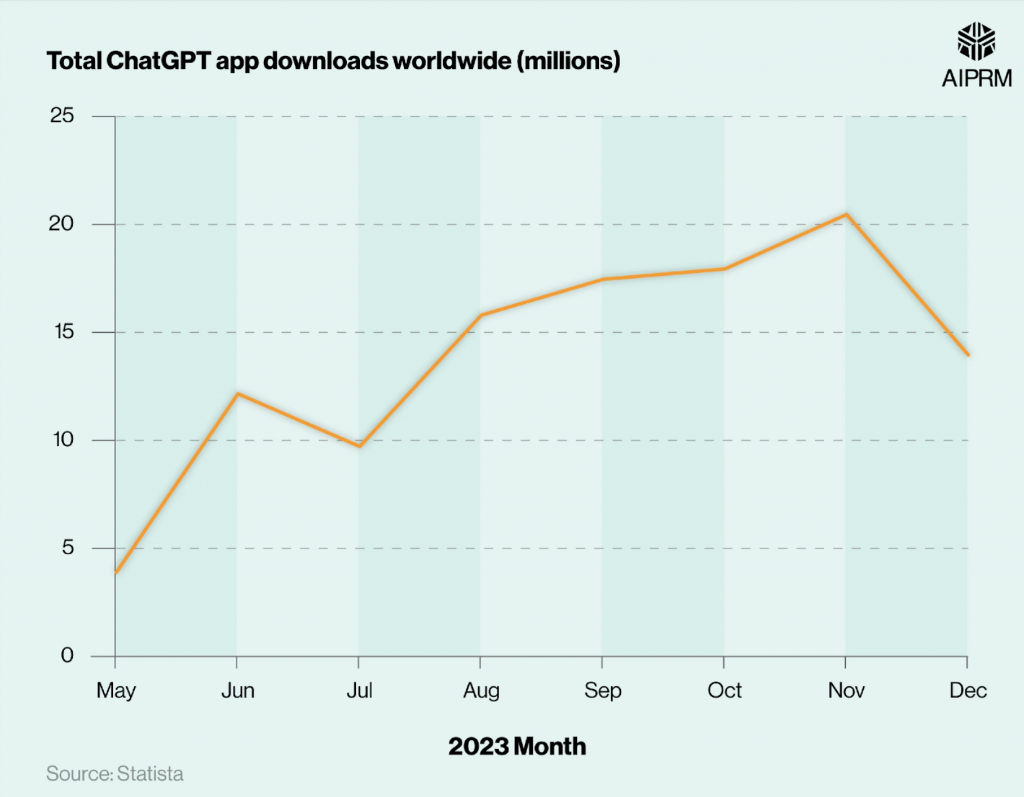

Oggi le cose sono migliorate con ChatGPT 4.0 – che corregge, ma lo fa con un certo garbo – e sempre più persone utilizzano il chatbot di OpenAI quotidianamente, dal PC o con l’app mobile (a questo proposito, SOSTariffe.it mette sempre a disposizione il suo comparatore per trovare l’offerta mobile più conveniente). Però il problema alla base dei LLM (Large Language Models), ovvero la frequenza delle allucinazioni, rimane. E se n’è accorta anche l’Unione Europea, ancora una volta in materia di dati sensibili e della loro protezione.

Il problema alla base: l’addestramento

Ma che cosa sono, in concreto, le allucinazioni dell’intelligenza artificiale? I chatbot (ma anche di generator di AI art, che ad esempio hanno molta difficoltà a riprodurre una scritta) “hanno le traveggole” quando non dispongono dei dati di addestramento necessari per rispondere a una domanda, ma forniscono comunque una risposta che sembra in tutto e per tutto fattuale. Le allucinazioni possono essere causate da diversi fattori, dai dati di addestramento inaccurati al sovraadattamento (ovvero quando un algoritmo non riesce a fare previsioni o a trarre conclusioni da dati diversi da quelli su cui è stato addestrato).

Le allucinazioni rappresentano uno dei maggiori problemi dei modelli AI generativi e non sono affatto facili da risolvere. Poiché i modelli AI vengono addestrati su vasti insiemi di dati, è difficile individuare problemi specifici nei dati stessi. Talvolta i dati utilizzati per l’addestramento dei modelli AI sono di per sé poco accurati, provenendo da fonti non proprio controllatissime, come ad esempio Reddit. Anche se i modelli AI sono progettati per non rispondere a domande sulle quali non conoscono la risposta, a volte, invece di rifiutare queste domande, generano risposte inesatte: un po’ come lo studente impreparato che, piuttosto che fare scena muta, ci prova.

Intelligenza artificiale: date di nascita sbagliate e guai col GDPR

Ora, OpenAI si trova nuovamente sotto la lente di ingrandimento dell’Unione Europea, questa volta per le allucinazioni di ChatGPT relative alle persone. Un gruppo no-profit per i diritti alla privacy chiamato noyb ha infatti presentato un reclamo presso l’Autorità Austriaca per la Protezione dei Dati (DPA) contro la compagnia di intelligenza artificiale. Il reclamo di noyb si concentra sul Regolamento Generale sulla Protezione dei Dati (il famoso GDPR) dell’UE, che regola come i dati personali delle persone nel blocco vengano raccolti e conservati.

Nonostante i requisiti del GDPR, “OpenAI ammette apertamente di non essere in grado di correggere le informazioni errate su ChatGPT”, ha dichiarato noyb, aggiungendo che la compagnia “non può dire da dove provengono i dati né quali dati ChatGPT conservi sulle singole persone” e che è “ben consapevole di questo problema, ma sembra non curarsene.”

Secondo il GDPR, gli individui nell’UE hanno il diritto di far correggere le informazioni errate su di loro, rendendo quindi OpenAI non conforme alla normativa a causa della sua incapacità di correggere i dati, ha affermato noyb nella sua denuncia.

Sebbene, secondo noyb, le allucinazioni “possano essere tollerate” in alcuni casi (ad esempio quando uno studente usa ChatGPT per aiutarlo con i compiti) sono “inaccettabili” quando si tratta di generare informazioni sulle persone. Il reclamante nel caso di noyb contro OpenAI è un personaggio pubblico che ha chiesto a ChatGPT la sua data di nascita, ma gli è stata ripetutamente fornita una risposta errata. OpenAI avrebbe poi rifiutato la sua richiesta di rettificare o cancellare i dati, sostenendo che non era possibile correggerli.

Privacy, il braccio di ferro con l’Europa

L’organizzazione no-profit chiede dunque alla DPA di indagare su come OpenAI elabori le risposte e come garantisca la correttezza dei dati personali durante l’addestramento dei suoi LLM. Noyb chiede anche alla DPA di imporre a OpenAI di adeguarsi alla richiesta del reclamante di accedere ai dati.

“L’obbligo di conformarsi alle richieste di accesso si applica a tutte le compagnie”, ha dichiarato Maartje de Graaf, avvocato per la protezione dei dati presso noyb. “È chiaramente possibile mantenere registrazioni dei dati di addestramento utilizzati per avere almeno un’idea sulle fonti delle informazioni. Sembra che, come con ogni ‘innovazione’, un altro gruppo di società ritenga che i suoi prodotti non debbano adeguarsi alla legge”. E ancora, a ribadire il concetto: “Se un sistema non può produrre risultati accurati e trasparenti, non può essere utilizzato per generare dati sulle persone. La tecnologia deve seguire i requisiti legali, non il contrario”.

Non è una questione da poco. Il mancato rispetto delle norme del GDPR può portare a sanzioni fino a 20 milioni di euro o il 4% del fatturato annuale globale, a seconda di quale valore sia più alto. Per giunta, OpenAI è già coinvolta in casi simili di protezione dei dati in Italia e in Polonia.

Come si ricorderà, infatti, dall’improvviso aumento di popolarità di ChatGPT gli strumenti AI generativi sono rapidamente entrati nel mirino delle autorità europee per la privacy. Tra gli altri, la DPA italiana ha affrontato l’inesattezza del chatbot imponendo una restrizione temporanea sul trattamento dei dati nel marzo 2023, che ha impedito per qualche settimana l’accesso. Poche settimane dopo, il Comitato Europeo per la Protezione dei Dati (EDPB) ha istituito un task force su ChatGPT per coordinare gli sforzi nazionali. Resta da vedere a cosa porterà.