Il web come lo abbiamo conosciuto fino a pochi anni fa potrebbe cambiare pelle e non solo. Alla centralità come pilone portante dell’architettura 2.0 si potrebbe sostituire una decentralizzazione crescente, sia di sistemi di calcolo, sia di sistemi di storage.

Fulcro di questo nuovo processo sono tecnologie di cui si comincia a parlare sempre più spesso, come ad esempio le soluzioni distributed ledger, ma anche nuove esigenze, come la necessità di sviluppare potenza di calcolo distribuita alla periferia della rete (edge computing).

Di fatto, lo sviluppo di un “web distribuito” sarà sempre di più in competizione con la centralizzazione del modello “cloud”.

Il terzo appuntamento con il ciclo dei Seminari Bordoni, promossi dalla Fondazione Ugo Bordoni, tenutosi oggi a Roma, presso l’oratorio del Gonfalone, dal titolo “Cloud distribuito, supercalcolo e web 3.0”, si è occupato proprio di questi temi e delle possibili strade da percorrere, tenendo sempre ben presente quelli che sono i fattori più critici su cui riflettere: sicurezza, privacy, sovranità e governo dei dati, innovazione, risorse, il tutto declinato in termini di imprese, ricerca e Pubblica Amministrazione (PA).

Introducendo il Seminario, Antonio Sassano, Presidente Fondazione Ugo Bordoni, ha subito fissato alcuni elementi chiave per favorire il confronto sul tema “web centralizzato o decentralizzato”, ad esempio il 5G e l’intelligenza artificiale (IA), che di per sé richiedono il “distributed web”.

Altro tema di massima rilevanza è la tecnologia edge computing, che potrebbe rappresentare il pillar dello sviluppo delle nuove reti, con la computazione che si sposta letteralmente ai bordi, nelle aree di confine, lì dove si trovano gli utenti finali.

C’è poi il problema della definizione precisa della proprietà dei dati e c’è il problema della cyber sicurezza di tipo “encrypt and distribute”, dove ogni computer è una cellula che si connette alle altre, cioè agli altri device, con il fine ultimo di costruire un supercomputer globale.

Un panorama si direbbe controintuitivo, se partiamo dal presupposto che oggi ancora si ha una forte tendenza alla concentrazione, con data center isolati, pochi supercalcolatori e un numero limitato di super piattaforme.

A questo punto la domanda suggerita da Sassano è: qual è dunque la direzione da prendere? Il mondo sembra andare verso la decentralizzazione, ma la scienza sembra voler prendere un’altra strada.

Paula Baran, uno degli storici inventori della commutazione di pacchetto, ha sempre pensato al futuro della rete come decentralizzato e diffuso, con il vantaggio di dare vita ad un sistema diffuso che, da un punto di vista della sicurezza, ad esempio, non è attaccabile in maniera fatale perché non ha un “centro di comando unico”, ma decentrato appunto, tenuto assieme da un’intelligenza distribuita.

Una seconda domanda potrebbe essere: il sogno di Baran si sta realizzando o stiamo assistendo ad un processo inverso?

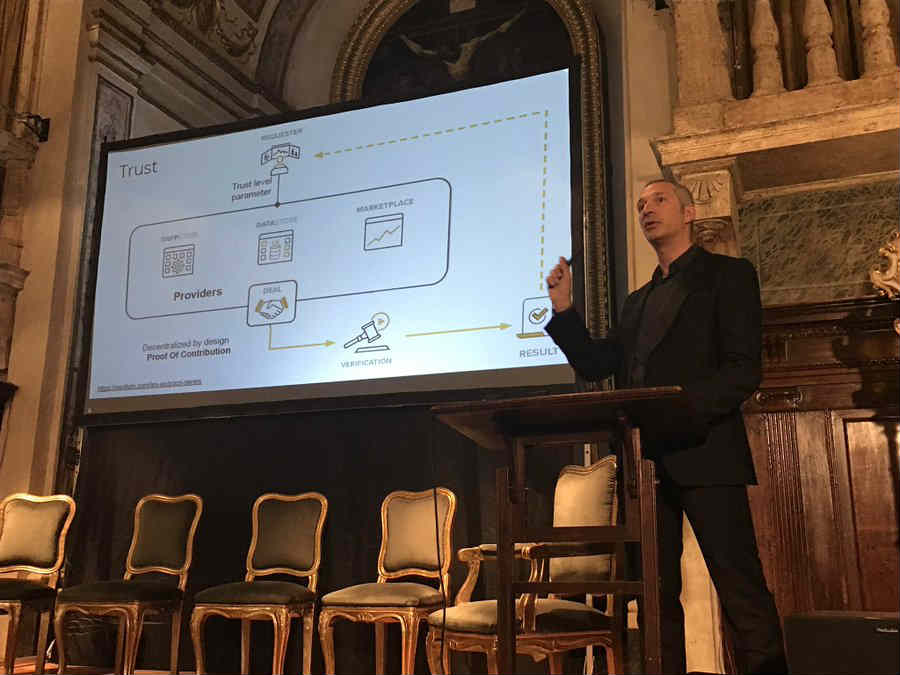

Di infrastrutture e marketplace decentralizzati, quindi sulla via tracciata da Baran, ha parlato il keynote speaker della mattinata, Gilles Fedak, cofondatore di iExec, azienda che fornisce servizi di cloud decentralizzati basati su blockchain.

Si tratta di realizzare un’infrastruttura di cloud virtuale in grado di fornire servizi di calcolo on demand di elevate prestazioni tramite soluzioni smart contracts ethereum, mentre l’dea di base è quella del desktop grid, cioè condividere volontariamente risorse di calcolo, raccogliendo su tutta internet risorse computazionali sottoutilizzate, in modo da eseguire applicazioni parallele molto ampie per una frazione del costo dei supercomputer tradizionali.

C’è poi la blockchain. Uno dei progetti su cui iExec sta lavorando è il protocollo Proof-of-Contribution, che favorirà meccanismi di assegnazione dei singoli blocchi della blockchain e della loro concatenazione in modo cooperativo anziché competitivo, portando a notevoli risparmi energetici.

Una sorta di passaggio generazionale della tecnologia, che offre così maggiori garanzie di trasparenza e sicurezza, fino all’arrivo delle applicazioni decentralizzate, o App, caratterizzate da forte autonomia, resilienza, immutabilità, con la proprietà di essere “unstoppable”, cioè non si possono arrestare.

Da qui discende la possibilità di arrivare ad infrastrutture e un market network decentralizzati, dove le applicazioni di big data e di calcolo ad elevate prestazioni, le basi di dati sensibili e di alto valore, oltre alle risorse computazionali saranno monetizzate sulla blockchain, come detto con i livelli più alti di trasparenza, resilienza e sicurezza.

Subito dopo ci sono stati i due interventi previsti nell’apertura di Seminario.

Giorgio Ventre, Consiglio di amministrazione Fondazione Ugo Bordoni, ha ricordato che “le risorse di calcolo federabili sono un’idea tipicamente europea. Siamo obbligati ad andare verso soluzioni decentralizzate, contro una tendenza generale che orienta alla centralizzazione, cosa di per sé rischiosa, perché rende il tutto più vulnerabile. Da qui discende l’urgenza di evitare ogni dipendenza, non solo tecnologica delle piattaforme. Dobbiamo quindi tutelare e valorizzare al meglio la nostra forza, la forza dell’Europa nel campo della ricerca e dell’innovazione”.

Decentralizzare, secondo Gilberto Nava, Co-chair IP, TMT, Data Protection Department, Chiomenti, significa anche “controllare un’enorme quantità di dati svincolati dai providers tradizionali”.

“Un cloud storage distribuito – ha affermato Nava – mitiga fortemente il rischio di interruzione dei servizi”. La decentralizzazione deve inoltre conciliarsi con il GDPR e permettere di identificare la catena dei responsabili del trattamento.

Altro tema è l’obbligo di minimizzazione dei dati, ossia il trattare i dati in modo adeguato limitatamente a quanto necessario rispetto alle finalità per i quali sono gestiti, a cui si affiancano il diritto all’accesso e il diritto all’oblio in tutti i nodi della rete.

La sfida alla centralizzazione, inoltre, sta tutta nel mercato finanziario e nel sistema bancario: “Dal 30 settembre 2019 si applicheranno alle banche e agli istituti di credito le linee guida dell’EBA in materia di esternalizzazione in cloud di funzioni aziendali e servizi. Stesso discorso per le assicurazioni con le indicazioni di EIOPA”.

Nella prima delle tre tavole rotonde previste dall’agenda del Seminario, dal titolo “Il supercalcolo nella ricerca in Italia”, moderata da Francesco Matera della Fondazione Ugo Bordoni, si è ulteriormente approfondito il tema della decentralizzazione della rete e della sua intelligenza.

“L’intelligenza artificiale è un driver speciale per lo sviluppo del supercalcolo. Le applicazioni dell’IA richiedono meno approssimazioni di calcolo, si progettano chip con un numero di bit inferiore”, ha detto Giuseppe Di Pietro, direttore ICAR-CNR.

“Ci sono i chip neuromorfici, in cui si simulano reti neuronali del nostro cervello, come l’Akida di BrainOnChip. Il “Summit”, invece, è il calcolatore più potente al mondo. Ha raggiunto un picco di prestazione di 3,3 exaops, mentre il deep learning trova applicazione sperimentale nella ricerca sul cancro e per lo studio del sistema biologico umano.

Fondamentalmente, per competere meglio si deve migliorare il livello di interazione tra i settori tecnologici, si devono distribuire le IA non il calcolo. L’evoluzione tecnologica ha preso questa strada: come sviluppare applicazioni di IA distribuita e che tipo di infrastrutture ideare”.

“La decentralizzazione offre nuove opportunità legate al gran numero di device e di dati generati, ma apre anche nuove sfide, dalla sicurezza alla privacy”, ha precisato Fabio Antonelli, Head of OpenIoT Research Unit della Fondazione Bruno Kessler.

“L’edge computing offre vantaggi legati alla velocità di reazione, alla facilità di gestione ed elaborazione di grandi quantità di dati minimizzando la richiesta di banda; maggiore sicurezza e garanzia di privacy.

Alcuni esempi e scenari sono dati dalle smart cities, dalla sorveglianza per la sicurezza delle strade e degli edifici, dalle applicazioni nella manifattura e nei trasporti autonomi”.

La seconda tavola rotonda, dal titolo “Il cloud nella PA: prospettive di sviluppo” è stata moderata da Raffaele Barberio, direttore di Key4biz.

Il messaggio del Seminario è che non c’è un pensiero piatto sul cloud, centrale e decentralizzato oppure nodale a reti. Sono emerse però alcune chiavi di lettura, tra cui le concentrazioni, la sicurezza, l’energia e la sostenibilità, la sovranità dei dati digitale di una nazione, con l’Europa che deve riuscire a riaffermare il concetto della terzietà.

“Sogei concentra i dati di milioni di italiani, centinaia di milioni di fatture elettroniche depositate. L’Italia – ha dichiarato Paolino Iorio, Direttore Service & Technology Innovation Hub Sogei – è al 25° posto nella classifica DESI, che è l’indice di digitalizzazione dell’economia e della società. Possiamo però riposizionarci rapidamente, ma serve impegno, non c’è solo la tecnologia a supporto della trasformazione digitale, molto dipende dalle risorse umane, su cui investire.

Il cloud è una delle leve tecnologiche per portare avanti tale trasformazione nel nostro Paese e uno degli strumenti che ci consentirebbe di migliorare il piazzamento, a patire dalla connettività.

Il cloud coputing è uno strumento di riduzione del digital divide e per la Pubblica Amministrazione ci sono diversi benefici: più sicurezza, ampia declinazione del cloud, ottimizzazione dell’uso dcelle risorse, maggiore capacità infrastrutturale e di servizio.

In avvio tutte le amministrazioni pubbliche si sono mosse ognuna per conto proprio, con scarsa coesione generale. Poi è arrivata la regolamentazione Agenzia per l’Italia Digitale, con i percorsi per qualificarsi come Cloud service provider o CSP e per realizzare i Poli Strategici Nazionali o PSN, tramite cui abilitare le amministrazioni all’uso delle tecnologie e soluzioni cloud disponibili, creando così le condizioni per una community cloud della PA. Necessaria in questo momento una riflessione strategica su alcuni aspetti pratici delle attuazioni: procurement, modalità di selezione e scelta, brokeraggio”.

“Abbiamo dovuto affrontare le medesime criticità in INAIL nell’implementare l’approccio cloud”, ha affermato Anna Sappa, Direzione centrale organizzazione digitale INAIL. “Stiamo realizzando diverse azioni, tra cui: piattaforme cloud private, migrazione sul cloud del parco applicativo stabile, rifacimento del sistema istituzionale dell’Istituto su OpenShift Docker, adozione soluzioni SAS e certamente la proposizione dell’Istituto come PSN. Vogliamo essere pronti a rendere l’infrastruttura portabile, a sviluppare un piano di reingegnerizzazione delle applicazioni con modelli di sviluppo agile in ottica microservizi ospitati in ambienti Platform as a service o PaaS e nel cloud e a realizzare un’estensione dell’infrastrututra di data center INAIL per includere la funzionalità disaster recovery”.

In Emilia Romagna, ha spiegato Gianluca Mazzini, Direttore generale Lepida, in-house della Regione Emilia-Romagna, “il comune più piccolo è Zerba, il più grande è Bologna, ed hanno gli stessi adempimenti. La sicurezza o l’efficienza è la stessa. Prima ognuno era lasciato a se stesso, ora si cammina assieme.

I problemi però sono numerosi nella trasformazione digitale degli enti. Il percorso cloud nella PA è lungo anni a livello regionale e attualmente ancora dobbiamo raggiungere l’ultimo step. La virtualizzazione del desktop, ad esempio, se obbliga l’utente a un tempo maggiore è un fallimento.

Il tempo di transito di un’operazione deve essere positiva. Siamo l’unico soggetto pubblico SPC, sistema pubblico di connettività, come operato nativo e ci abbiamo messo molto tempo.

Il cloud deve essere accessibile quando ne ho bisogno e quando si può. Va rivisto il sistema amministrativo su questo punto. Due i punti chiave: diventare cloud service provider e diventare polo strategico nazionale o PSN come evoluzione del CSP. Il modello federato che mette assieme realtà codificate ha un senso per superare la polverizzazione, ma servono regole precise, le qualifiche (marketplace) e maggiore concertazione”.

“Siamo censiti come PSN e qualificati come CSP – ha detto nel suo intervento Pietro Pacini, Direttore generale CSI Piemonte, altra in-house, stavolta della Regione Piemonte – gestiamo nel nostro data center tutti i dati dei soci. In questo modo abbiamo superato il processo di moving delle infrastrutture proprietarie. Periodicamente facciamo incontri con i soci per stimolare, attraverso il tema della sicurezza, la rilevanza del luogo dove sono gestiti i dati. Il nostro certificato CSP garantisce questo: dove sono i dati e la distanza (latenza) sono due elementi fondamentali, assieme alla sicurezza.

Su PSN e CSP, è difficile immaginare che il luogo in cui è gestito il cloud si possa smontare e ricostruire altrove, si deve ragionare che certamente esistono realtà territoriali e strutture dedicate che possono essere razionalizzate, ma esistono una pluralità di soggetti di medie dimensioni che difficilmente possono smontare il proprio data center per rimontarlo chissà dove.

È troppo oneroso questo processo e anche complesso e rischioso in termini di sicurezza”.

“Dopo il primo piano triennale sono stati avviati i primi percorsi di qualificazione dei CSP e il censimento degli stessi”, ha dichiarato Adriana Agrimi, Dirigente Area Trasformazione Digitale, AgID. “Da qui si parte per sviluppare una strategia nazionale. Siamo di fronte ad un cambio di paradigma e non può essere circoscritto in una circolare. Abbiamo maturato il risultato delle due fasi del censimento, che ci ha permesso di comprendere il fattore culturale e di introdurre delle precisazioni.

Dobbiamo chiarire gli elementi tecnici di qualificazione delle infrastrutture che poi potranno essere utilizzate dai PSN.

Il piano triennale vede pronte entro maggio la circolare per la definizione dei criteri necessari alla qualifica per diventare PSN.

Vogliamo affiancare le PA con in programma di cloud learning perché altrimenti il cambiamento sarà più lungo e complesso. Va inoltre aggiornato il quadro sulla sicurezza informatica”.

La terza tavola rotonda prevista dal Seminario, dal titolo “Verso il cloud decentralizzato: la visione delle imprese”, moderata da Luca Rea, Fondazione Ugo Bordoni, è stata invece declinata sulle strategie delle imprese.

“La disponibilità e diffusione di abilitatori tecnologici accelerano l’evoluzione digitale di tutti i settori industriali, così come della PA e dei servizi per i consumatori. L’intera evoluzione si basa su una “architettura” logica digitale in cui la connettività gioca in ruolo centrale“, ha spiegato Riccardo Mascolo, Head of Strategy and Business Development Ericsson Italy.

“L’evoluzione della connettività mobile verso il 5G abilita nuovi livelli dell’esperienza d’uso dei servizi in cloud. Sta aumentando nel mercato la consapevolezza delle potenzialità aperte dal 5G e l’aspettativa per i nuovi servizi abilitati”.

“Il 5G – ha poi precisato Mascolo – è stato disegnato e progettato a partire dai casi d’uso (industriali e consumer) e dall’esperienza di servizio che deve essere garantita per renderli utilizzabili. Il 5G è acceleratore dell’evoluzione di servizi cloud e allo stesso tempo, per garantire i livelli di esperienza alla base dell’utilizzabilità di questi servizi fa uso del cloud distribuito”.

In tema di decentralizzazione, ha affermato Bruno Bianchini, Head of Infrastructure and Technological Services Enel, “da metà aprile siamo full cloud e abbiamo ridisegnato la rete dove l’edge computing è realtà. Il 5G abiliterà nuovi servizi e aumenterà la resilienza, portandoci ad una capacità elaborativa di prossimità”.

“Dal 2015 – ha proseguito il manager – abbiamo iniziato il cambiamento con il cloud, con savings economici enormi, nelle operazioni e nella velocità, nella resilienza dei sistemi. In termini di controllo dati, per aziende multinazionali come la nostra, abbiamo controllo e governo pieno a casa.

Sapere con esattezza dove sta la proprietà dei dati tra un nodo e un altro non è semplice, ma acquisterà crescente importanza strategica.

Tramite droni, ad esempio, possiamo monitorare le nostre reti elettriche e quindi ottimizzare tutti i passaggi relativi agli interventi, creando savings e garantendo massima sicurezza. Cosa che non sarebbe possibile senza il cloud”.

Un tema centrale, da cui partire per i prossimi sviluppi delle tecnologie cloud, ha invece sottolineato i un video intervento Stefano Onofri, CEO Cubbit, è che “fuori dei data center, a casa e in ufficio, c’è tanto valore da cui partire per sviluppare servizi distribuiti di cloud”.

“Il cloud oggi guarda al destinatario, all’utente finale. Noi vendiamo “trust”, non solo tecnologia, perché il device ci consegna dei dati che vanno gestiti e protetti. Gli stessi clienti sono spesso sviluppatori e produttori di contenuti. Il mercato privato ha un dinamismo elevato e ci permette di vendere soluzioni per lo sviluppo di soluzioni tecnologiche avanzate. L’edge, possiamo dire, sono tutti coloro che producono contenuti e sviluppano servizi”, ha detto Pier Luigi Dal Pino, Direttore Centrale relazioni istituzionali ed industriali Microsoft.

“Mancano le regole sugli acquisti, sulle nuove forme di collaborazione tra PA e imprese, e mancano le competenze digitali, un investimento a livello di intero Paese che è fondamentale.

Gli stessi smart device diventeranno dei centri servizi cloud, proprio per garantire all’utente il massimo dell’esperienza in modalità decentralizzata. Tanti ending point che a loro volta genereranno dati. Nel 2022 la metà dei dati relativi ad un cloud center saranno prodotti proprio dal confine, dall’edge”.

“Fare cloud significa aiutare le piccole e medie imprese ad operare sul mercato, a renderle più competitive e a sviluppare servizi più innovativi. Il dato deve risiedere sul territorio, che sia locale, o nazionale, per garantire la continuità fisica e giuridica dei dati stessi. Il 5G sarà fondamentale per la distribuzione, sia nella raccolta dati, sia nell’offerta di servizi”, ha affermato Michele Zunino, CEO Netalia

“Abbiamo 12mila uffici e 130 mila dipendenti e da qui partiamo per confrontarci con 34 milioni di clienti che hanno esigenze diverse e crescenti. Essi rappresentano anche i giovani, soggetto singolare che stimola servizi in logica diversa. Il 35% dei clienti di Poste è composto da giovani, che sappiamo essere sensibili all’innovazione, soprattutto nei servizi”, ha ricordato Monica Pilleddu, Regulation Manager – Regolamentazione mercato servizi digitali Poste Italiane.

“La flessibilità è strategica in un’organizzazione di grandi dimensioni, soprattutto in relazione al mercato, tanto da esser parte integrante del piano 2020-2022 per la trasformazione digitale di Poste. Gli investimenti sono altro elemento chiave, perché in una visione prospettica rendere disponibili servizi innovativi per cittadini, imprese e PA. Altro elemento strategico del Piano è il cloud, sia in veste di abilitatori, sia di utilizzatori”.

Le conclusioni del Seminario Bordoni sono state infine affidate a Marco Bellezza, Consigliere del Ministro dello sviluppo economico, che propone alcune riflessioni relative alla trasformazione digitale e al sistema Paese: “la rilevanza della sovranità dei dati dei cittadini e delle imprese, noi dobbiamo prima di tutto trovare degli ambiti in cui esercitare tale sovranità, come nel settore delle startup, che vanno aiutate e sostenute a livello nazionale, come il Fondo nazionale innovazione, mobilitando nuove risorse, anche pubbliche, che coniugano il giusto intervento dello Stato e la promozione delle eccellenze made in Italy; il tema della sicurezza, in particolare per il 5G, ma anche altri settori rilevanti per la crescita del Paese; il tema della decentralizzazione, che assicura maggiore controllo, minore dipendenza dalle tecnologie e dai player tecnologici, lo stesso Ministero sta lavorando sulla decentralizzazione; quindi l’identità digitale, per cui di fatto ne basta una per l’accesso a tutte le piattaforme esistenti della PA e i loro servizi, ma dobbiamo arrivare ad un unico sistema di identificazione digitale; i dati dei cittadini, infine, devono essere maggiormente tutelati e protetti”.